IBM

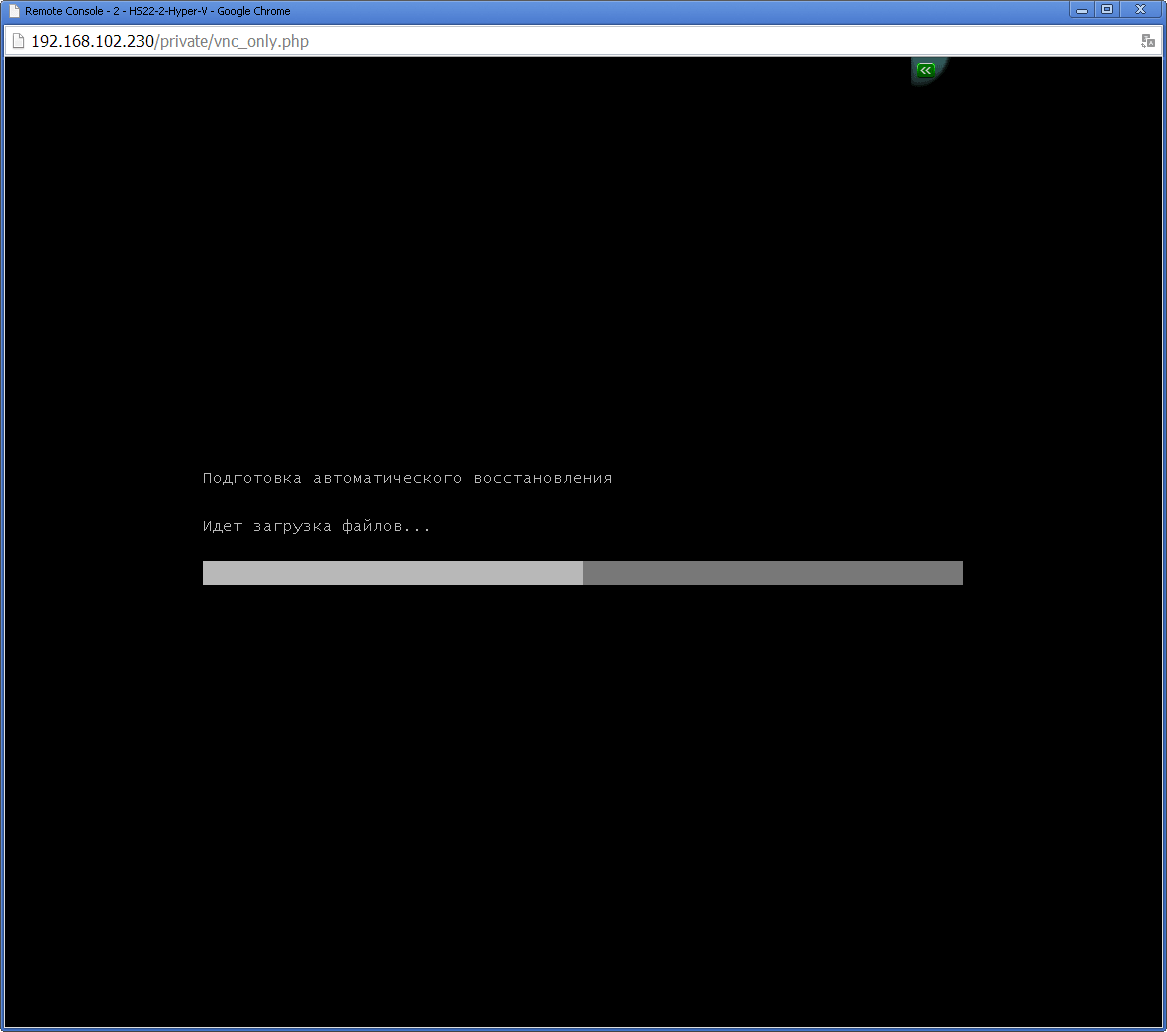

Встала задача обновить blade корзину из 14 штук в плане прошивок и все такое, все обновились нормально кроме одного. Пробовал обновлять автоматическим диском, не получилось обновил вручную. Думаю ну все хорошо, но как обычно мелкософт поднасрал. При загрузке блейда я увидел подготовка автоматического восстановления и белый ползунок

Hyper-V

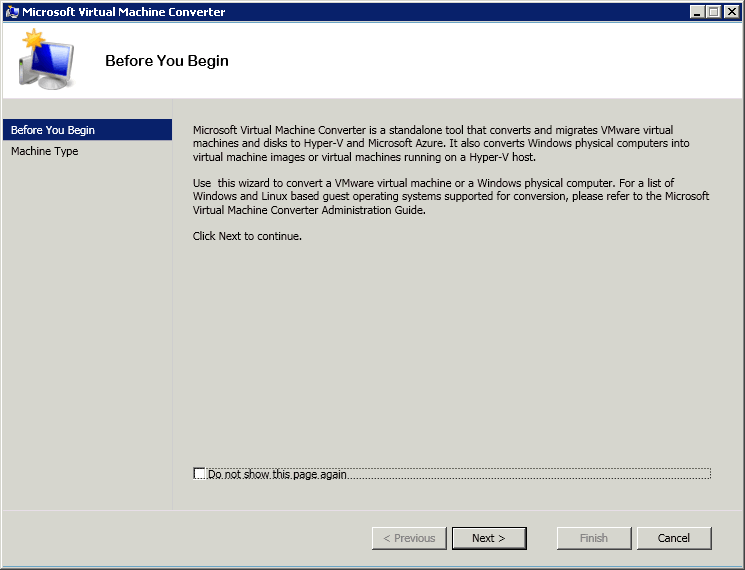

Hyper-V Добрый день! Уважаемые пользователи и читатели IT блога Pyatilistnik.org. В прошлый раз я с вами поделился дистрибутивом полезного софта HP Download Manager 4.3. Сегодня мы то же коснемся серверного сегмента и поговорим про виртуализацию на основе гипервизора Microsoft, задача научиться устанавливать конвертер Virtual Machine Converter 3.1. Рассмотрим какие у него функции, чем он может помочь инженеру в повседневной работе. Думаю, что для начинающих коллега данная информация будет полезна к прочтению и использованию.

Добрый день! Уважаемые пользователи и читатели IT блога Pyatilistnik.org. В прошлый раз я с вами поделился дистрибутивом полезного софта HP Download Manager 4.3. Сегодня мы то же коснемся серверного сегмента и поговорим про виртуализацию на основе гипервизора Microsoft, задача научиться устанавливать конвертер Virtual Machine Converter 3.1. Рассмотрим какие у него функции, чем он может помочь инженеру в повседневной работе. Думаю, что для начинающих коллега данная информация будет полезна к прочтению и использованию.

Добрый день! Уважаемые пользователи и читатели IT блога Pyatilistnik.org. В прошлый раз я с вами поделился дистрибутивом полезного софта HP Download Manager 4.3. Сегодня мы то же коснемся серверного сегмента и поговорим про виртуализацию на основе гипервизора Microsoft, задача научиться устанавливать конвертер Virtual Machine Converter 3.1. Рассмотрим какие у него функции, чем он может помочь инженеру в повседневной работе. Думаю, что для начинающих коллега данная информация будет полезна к прочтению и использованию.

Добрый день! Уважаемые пользователи и читатели IT блога Pyatilistnik.org. В прошлый раз я с вами поделился дистрибутивом полезного софта HP Download Manager 4.3. Сегодня мы то же коснемся серверного сегмента и поговорим про виртуализацию на основе гипервизора Microsoft, задача научиться устанавливать конвертер Virtual Machine Converter 3.1. Рассмотрим какие у него функции, чем он может помочь инженеру в повседневной работе. Думаю, что для начинающих коллега данная информация будет полезна к прочтению и использованию. Hyper-V Вчера на одном из официальных ресурсов софтверной корпорации – Microsoft TechNet, который в свою очередь был создан для специалистов, осуществляющих, как внедрение, поддержку, а также планирование решений Майкрософт появилась информация о том, что всем желающим уже доступна новоиспеченная версия Microsoft Virtual Machine Converter 3.0 (MVMC). В первую очередь MVMC предназначен для конвертации виртуальных дисков VMware в Hyper-V, после чего, последние могут быть загружены пользователем в облачную среду Windows AZURE.

Вчера на одном из официальных ресурсов софтверной корпорации – Microsoft TechNet, который в свою очередь был создан для специалистов, осуществляющих, как внедрение, поддержку, а также планирование решений Майкрософт появилась информация о том, что всем желающим уже доступна новоиспеченная версия Microsoft Virtual Machine Converter 3.0 (MVMC). В первую очередь MVMC предназначен для конвертации виртуальных дисков VMware в Hyper-V, после чего, последние могут быть загружены пользователем в облачную среду Windows AZURE.

Вчера на одном из официальных ресурсов софтверной корпорации – Microsoft TechNet, который в свою очередь был создан для специалистов, осуществляющих, как внедрение, поддержку, а также планирование решений Майкрософт появилась информация о том, что всем желающим уже доступна новоиспеченная версия Microsoft Virtual Machine Converter 3.0 (MVMC). В первую очередь MVMC предназначен для конвертации виртуальных дисков VMware в Hyper-V, после чего, последние могут быть загружены пользователем в облачную среду Windows AZURE.

Вчера на одном из официальных ресурсов софтверной корпорации – Microsoft TechNet, который в свою очередь был создан для специалистов, осуществляющих, как внедрение, поддержку, а также планирование решений Майкрософт появилась информация о том, что всем желающим уже доступна новоиспеченная версия Microsoft Virtual Machine Converter 3.0 (MVMC). В первую очередь MVMC предназначен для конвертации виртуальных дисков VMware в Hyper-V, после чего, последние могут быть загружены пользователем в облачную среду Windows AZURE. Vmware, VirtualBox Добрый день! Уважаемые читатели и гости популярного IT портала pyatilistnik.org. Задача простая, уменьшить размер виртуального диска vmdk в ESXI 5 или 6.5. Такая нужда может возникнуть при не правильном планировании, или просто из-за неправильной информации со стороны человека ставящего задачу. Что имеем, есть виртуальная машина с windows server 2008 R2 диск C 50 гб занято 20 гб и диск D 100гб, а используется 1, нужно его уменьшить, до 10 скажем и чтобы он остался толстым. К сожалению штатными средствами, это сделать не получится, это не как в Hyper-V зашел в настройки и отнял нужное количество. Но есть к счастью не муторный способ, это решить, а именно утилита VMware vCenter Converter Standalone 5-6.2, пример ее работы я описал тут (виртуализация физической машины).

Добрый день! Уважаемые читатели и гости популярного IT портала pyatilistnik.org. Задача простая, уменьшить размер виртуального диска vmdk в ESXI 5 или 6.5. Такая нужда может возникнуть при не правильном планировании, или просто из-за неправильной информации со стороны человека ставящего задачу. Что имеем, есть виртуальная машина с windows server 2008 R2 диск C 50 гб занято 20 гб и диск D 100гб, а используется 1, нужно его уменьшить, до 10 скажем и чтобы он остался толстым. К сожалению штатными средствами, это сделать не получится, это не как в Hyper-V зашел в настройки и отнял нужное количество. Но есть к счастью не муторный способ, это решить, а именно утилита VMware vCenter Converter Standalone 5-6.2, пример ее работы я описал тут (виртуализация физической машины).

Добрый день! Уважаемые читатели и гости популярного IT портала pyatilistnik.org. Задача простая, уменьшить размер виртуального диска vmdk в ESXI 5 или 6.5. Такая нужда может возникнуть при не правильном планировании, или просто из-за неправильной информации со стороны человека ставящего задачу. Что имеем, есть виртуальная машина с windows server 2008 R2 диск C 50 гб занято 20 гб и диск D 100гб, а используется 1, нужно его уменьшить, до 10 скажем и чтобы он остался толстым. К сожалению штатными средствами, это сделать не получится, это не как в Hyper-V зашел в настройки и отнял нужное количество. Но есть к счастью не муторный способ, это решить, а именно утилита VMware vCenter Converter Standalone 5-6.2, пример ее работы я описал тут (виртуализация физической машины).

Добрый день! Уважаемые читатели и гости популярного IT портала pyatilistnik.org. Задача простая, уменьшить размер виртуального диска vmdk в ESXI 5 или 6.5. Такая нужда может возникнуть при не правильном планировании, или просто из-за неправильной информации со стороны человека ставящего задачу. Что имеем, есть виртуальная машина с windows server 2008 R2 диск C 50 гб занято 20 гб и диск D 100гб, а используется 1, нужно его уменьшить, до 10 скажем и чтобы он остался толстым. К сожалению штатными средствами, это сделать не получится, это не как в Hyper-V зашел в настройки и отнял нужное количество. Но есть к счастью не муторный способ, это решить, а именно утилита VMware vCenter Converter Standalone 5-6.2, пример ее работы я описал тут (виртуализация физической машины). Vmware, VirtualBox Встала задача, переконвертировать виртуальную машину из Hyper-V 3.0 vhdx в ESXI 5.5 vmdk. Ни на йоту не сомневался что мне поможет VMware vCenter Converter Standalone 5.x.x, но он мне написал, что это не поддерживается скачай мол новую версию, хотя уже была самой последней 218.Полазив по интернету понял, что все что уже предлагается очень муторно. Пробовал starwind не проканал, на сайте vmware есть инструкция из 6 пунктов и 6 разных конвертаций, муторно!!!! До этого мне пришлось виртуализовывать железный сервер все тем же VMware vCenter Converter Standalone 5.x.x тут все описано. Дай думаю попробую. Когда все закончилось, то виртуалка на ESXI5.5 поднялась без проблем, погоняв ее пару дней я удостоверился что синих экранов нет и все перенеслось корректно. Надеюсь vmware допилит свой конвертер, до ума. Так же советую прочитать Как сконвертировать vhdx в vmdx с помощью StarWind V2V Converter V8

Встала задача, переконвертировать виртуальную машину из Hyper-V 3.0 vhdx в ESXI 5.5 vmdk. Ни на йоту не сомневался что мне поможет VMware vCenter Converter Standalone 5.x.x, но он мне написал, что это не поддерживается скачай мол новую версию, хотя уже была самой последней 218.Полазив по интернету понял, что все что уже предлагается очень муторно. Пробовал starwind не проканал, на сайте vmware есть инструкция из 6 пунктов и 6 разных конвертаций, муторно!!!! До этого мне пришлось виртуализовывать железный сервер все тем же VMware vCenter Converter Standalone 5.x.x тут все описано. Дай думаю попробую. Когда все закончилось, то виртуалка на ESXI5.5 поднялась без проблем, погоняв ее пару дней я удостоверился что синих экранов нет и все перенеслось корректно. Надеюсь vmware допилит свой конвертер, до ума. Так же советую прочитать Как сконвертировать vhdx в vmdx с помощью StarWind V2V Converter V8

Встала задача, переконвертировать виртуальную машину из Hyper-V 3.0 vhdx в ESXI 5.5 vmdk. Ни на йоту не сомневался что мне поможет VMware vCenter Converter Standalone 5.x.x, но он мне написал, что это не поддерживается скачай мол новую версию, хотя уже была самой последней 218.Полазив по интернету понял, что все что уже предлагается очень муторно. Пробовал starwind не проканал, на сайте vmware есть инструкция из 6 пунктов и 6 разных конвертаций, муторно!!!! До этого мне пришлось виртуализовывать железный сервер все тем же VMware vCenter Converter Standalone 5.x.x тут все описано. Дай думаю попробую. Когда все закончилось, то виртуалка на ESXI5.5 поднялась без проблем, погоняв ее пару дней я удостоверился что синих экранов нет и все перенеслось корректно. Надеюсь vmware допилит свой конвертер, до ума. Так же советую прочитать Как сконвертировать vhdx в vmdx с помощью StarWind V2V Converter V8

Встала задача, переконвертировать виртуальную машину из Hyper-V 3.0 vhdx в ESXI 5.5 vmdk. Ни на йоту не сомневался что мне поможет VMware vCenter Converter Standalone 5.x.x, но он мне написал, что это не поддерживается скачай мол новую версию, хотя уже была самой последней 218.Полазив по интернету понял, что все что уже предлагается очень муторно. Пробовал starwind не проканал, на сайте vmware есть инструкция из 6 пунктов и 6 разных конвертаций, муторно!!!! До этого мне пришлось виртуализовывать железный сервер все тем же VMware vCenter Converter Standalone 5.x.x тут все описано. Дай думаю попробую. Когда все закончилось, то виртуалка на ESXI5.5 поднялась без проблем, погоняв ее пару дней я удостоверился что синих экранов нет и все перенеслось корректно. Надеюсь vmware допилит свой конвертер, до ума. Так же советую прочитать Как сконвертировать vhdx в vmdx с помощью StarWind V2V Converter V8 Utilities Вам понравился диск, и вы захотели его оставить себе, а диск друга, который просит его обратно. И тут возникает вопрос: «Как же мне его у себя оставить и другу диск вернуть?». Ответ прост, надо сделать образ (полную копию диска). А как его сделать, я расскажу Вам на примере бесплатной программы «Ashampoo Burning Studio 6 FREE». Мы будем создавать образ диска в формате ISO, это самый распространенный формат и можно сказать некий стандарт в данной области, который вы встретите в 95% случаев.

Вам понравился диск, и вы захотели его оставить себе, а диск друга, который просит его обратно. И тут возникает вопрос: «Как же мне его у себя оставить и другу диск вернуть?». Ответ прост, надо сделать образ (полную копию диска). А как его сделать, я расскажу Вам на примере бесплатной программы «Ashampoo Burning Studio 6 FREE». Мы будем создавать образ диска в формате ISO, это самый распространенный формат и можно сказать некий стандарт в данной области, который вы встретите в 95% случаев.

Вам понравился диск, и вы захотели его оставить себе, а диск друга, который просит его обратно. И тут возникает вопрос: «Как же мне его у себя оставить и другу диск вернуть?». Ответ прост, надо сделать образ (полную копию диска). А как его сделать, я расскажу Вам на примере бесплатной программы «Ashampoo Burning Studio 6 FREE». Мы будем создавать образ диска в формате ISO, это самый распространенный формат и можно сказать некий стандарт в данной области, который вы встретите в 95% случаев.

Вам понравился диск, и вы захотели его оставить себе, а диск друга, который просит его обратно. И тут возникает вопрос: «Как же мне его у себя оставить и другу диск вернуть?». Ответ прост, надо сделать образ (полную копию диска). А как его сделать, я расскажу Вам на примере бесплатной программы «Ashampoo Burning Studio 6 FREE». Мы будем создавать образ диска в формате ISO, это самый распространенный формат и можно сказать некий стандарт в данной области, который вы встретите в 95% случаев. Windows 2008/2008 R2

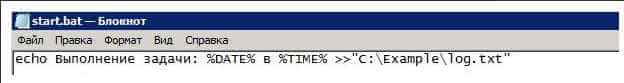

0. Задача:

Предположим, что нам надо запускать файл «С:\Example\start.bat» в течении суток каждые 20 мин. Файл start.bat будет просто записывать в текстовый файл log.txt время своего запуска. Вот его содержание: