Как создать robots.txt в ManageEngine ServiceDesk

Добрый день! Уважаемые читатели и гости одного из крупнейших IT блогов по системному администрированию Pyatilistnik.org. В прошлый раз мы с вами успешно разобрали настройку оборудования Mikrotik и тестирование его пропускной способности в нашей локальной сети через утилиту Iperf. В сегодняшней заметке мы немного поговорим про сео. а именно разберемся как запретить поисковым системам индексировать ваши корпоративные ресурсы выставленные на внешнем адресе, покажу я это на примере системы ManageEngine ServiceDesk 11.

Добрый день! Уважаемые читатели и гости одного из крупнейших IT блогов по системному администрированию Pyatilistnik.org. В прошлый раз мы с вами успешно разобрали настройку оборудования Mikrotik и тестирование его пропускной способности в нашей локальной сети через утилиту Iperf. В сегодняшней заметке мы немного поговорим про сео. а именно разберемся как запретить поисковым системам индексировать ваши корпоративные ресурсы выставленные на внешнем адресе, покажу я это на примере системы ManageEngine ServiceDesk 11.

Для чего нужен файл Robots.txt

О том, что из себя представляет файл robots.txt, я подробно рассказывал по ссылке слева. Если в двух словах, то это специальный файл, который дает рекомендации для поисковых роботов, как нужно взаимодействовать с сайтов, что нужно индексировать и в дальнейшем отображать в поисковой выдачи (Например Google или Яндекс), а что нет.

Делается это по ряду причин:

- Удаляются дубликаты страниц сайта - это нужно для того, чтобы поисковые системы не тратили свои мощности впустую, никому не нужны одни и те же страницы с идентичным содержимым по сотне разных адресов

- У вас есть возможность запретить к индексированию как отдельных частей, разделов сайта. так и его полное индексирование. Делается, это для того, чтобы нельзя было найти в поисковой строке ссылку на вас. В моем случае, это и есть основная задача.

Куда подкладывать файл robots.txt в ManageEngine ServiceDesk

Поисковые роботы находят файл robots.txt по стандартному пути:

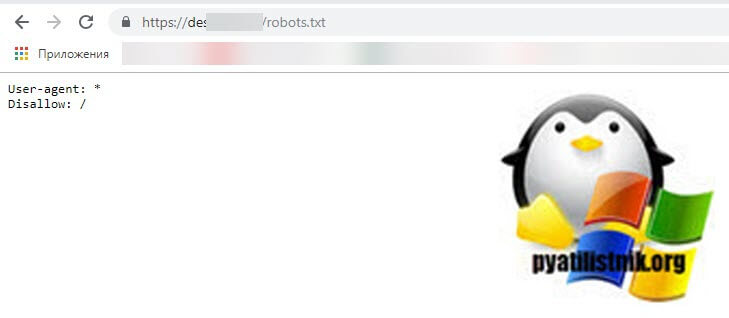

Вот вам пример моего файла robots.txt.

Если вы попытаетесь посмотреть файл robots.txt на своем ManageEngine ServiceDesk, то получите "404 ошибку. К сожалению, запрашиваемая страница не существует". Давайте это поправим.

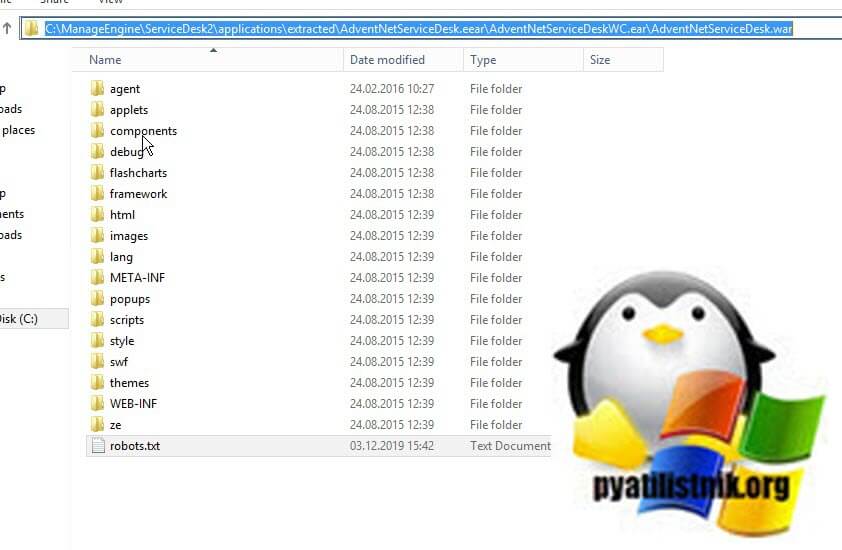

Если у вас ManageEngine ServiceDesk 9.4 и старее, то вам необходимо положить файл robots.txt в расположение:

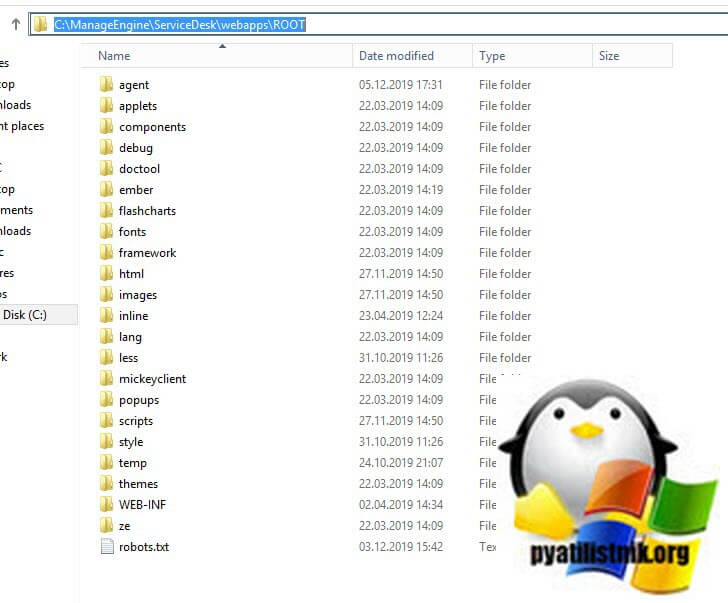

Если у вас ManageEngine ServiceDesk выше чем 9.4, то путь будет вот такой:

Еще хочу отметить, что ранее я обновлялся с ManageEngine ServiceDesk 9.3 до 11007 и мне пришлось подкладывать файл по первому пути (C:\ManageEngine\ServiceDesk\webapps\ROOT), так как папки applications у меня не было, это то же нужно учитывать, если же у вас была чистая установка, то пути будут неизменны.

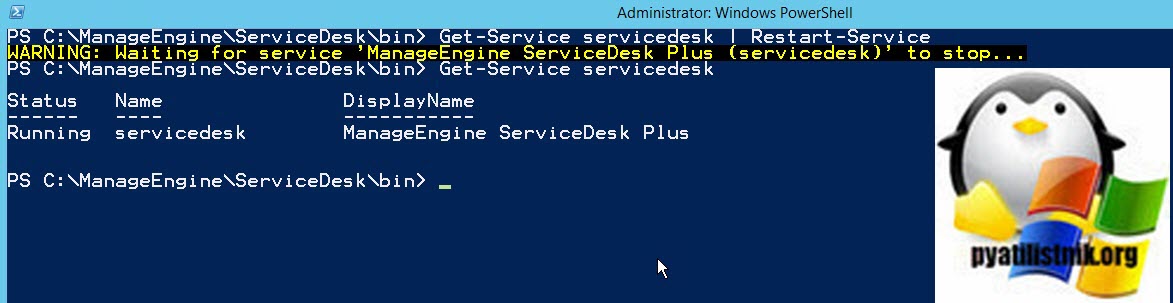

После того, как файл помещен в нужное расположение вам необходимо открыть PowerShell и перезапустить службу ManageEngine ServiceDesk через команду:

Пробуем посмотреть появился ли наш файл robots.txt, в моем примере все отлично, я вижу что он есть и он запрещает полную индексацию.

Disallow: /

Как видите все очень просто и у вас есть возможность выбирать и задавать явным образом общение вашего ресурса с поисковыми роботами. На этом у меня все, с вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org.