Дисковая архитектура Vmware ESXI

Всем привет сегодня мне хочется рассказать, как работает Vmware ESXI на уровне дисковой подсистемы, с какими протоколами дружит. Рассмотрим архитектуру дисковой подсистемы, будет интересно. Хочу отметить, что производительность всей инфраструктуры, будет на 90 процентов зависеть именно от этого фактора, и правильное его понимание, будет служить залогом лучшего планирования и функционирования, советую выделить для своего обучения минут 15-20 и вы сможете потом избежать, большого количества всевозможных проблем.

Не так давно я писал статью о том что такое виртуализация и ее принцип работы VMware ESXI, советую ознакомится, там я в общих чертах рассказал как работает сам ESXi и посмотрели сравнения с физической инфраструктурой. Далее я хотел бы рассказать о каждой из его составляющих более подробно.

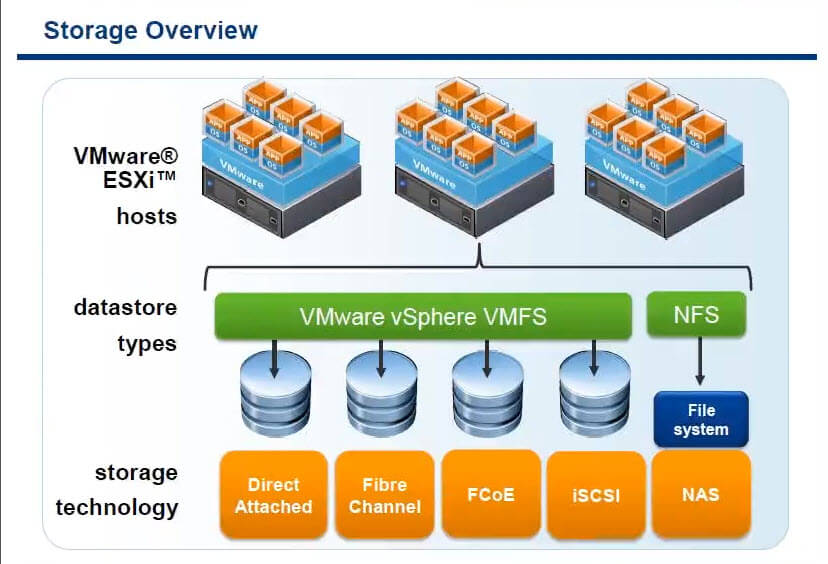

Storage архитектура

На скриншоте снизу представлена схема работы ESXI с дисками. Есть хосты виртуализации, к ним по протоколам

- NAS > подключение NFS по сети

- ISCSI > тоже по ethernet сети

- FCoE

- FC > оптика

- Direct Attached (DAS)

Далее эти дисковые ресурсы, видятся в гипервизоре как LUN разделы, которые подключаются и форматируются в VMFS файловую систему.

Ограничения подключений

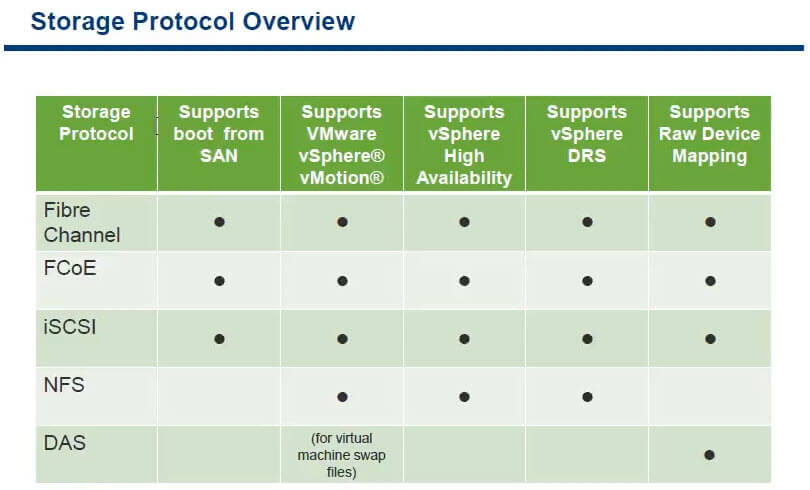

Как известно каждый метод подключения несет в себе как плюсы так и минусы, один что то умеет, а второй нет. Ниже мы рассмотрим сводную таблицу, в которой отражены виды подключений и какие функции vCenter в них работают.

Как можно заметить что загружаться с СХД (SAN) могут только FC, ISCSI и FCoE, NFS это не умеет так как работает не на блочном уровне, а на файловом. Ниже я расскажу, в чем разница. Первая тройка поддерживает все фишки vCenter

В чем разница, блочный в большинстве случаев быстрее, простой пример вам нужно прочитать 1 блок файла в 100 мб, при блочном доступе вы получите нужный блок сразу, при файловом доступе вы должны считать файл полностью и только потом получить нужную часть файла.

- vMotion

- HA > высокодоступный кластер

- DRS

- Raw Device Mapping > проброс реального оборудования в виртуальную машину.

NFS по некоторым пунктам отстает, DAS как вы сами понимаете, логично что их не использует, так как по сути это собственные диски вставленные в сервер с гипервизором.

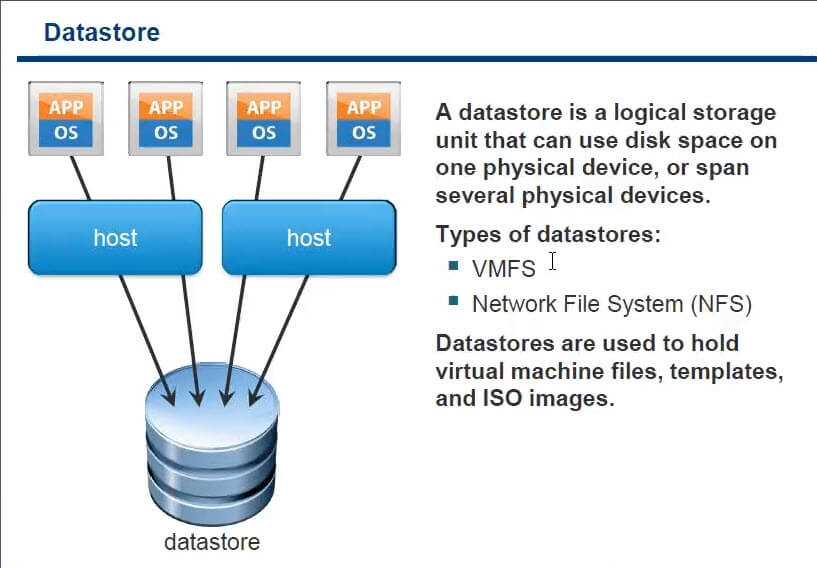

После того как вы разметили lun у вас он будет либо формата vmfs либо nfs. Если вы подключили NFS шару, она не отформатируется в VMFS а будет именно NFS. Ниже представлен скрин, как работаю виртуальные машины на datastore. Есть приложение в ОС, которое крутится в виртуалке, та в свою очередь работает на определенном хосте и хранит свои файлы виртуальной машины на определенном datastore.

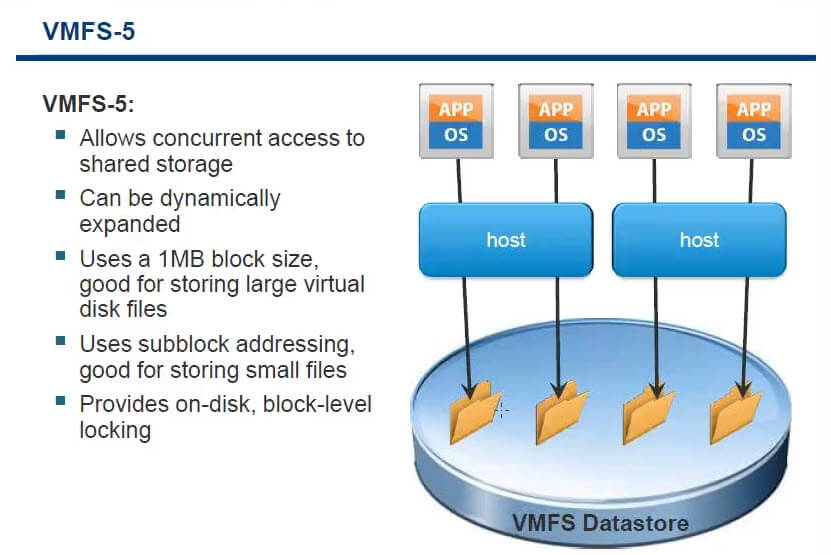

VMFS 5

И так файловая система VMFS5 самая новая на текущий момент у VMware. Основные достоинства

- Общий доступ

- Можно динамически расширять

- Размер блока 1 мб, больше нет необходимости париться про, то какой размер блока выбрать

- Блочный доступ

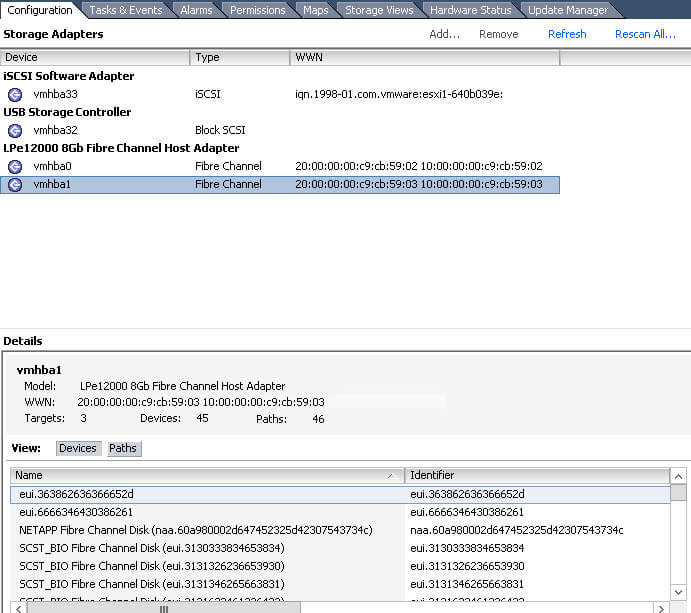

Устройства подключения к дисковым ресурсам в esxi называются как vmhba (виртуальный host bus adapter), есть ISCSI программный, есть fc как в моем случае. Посмотреть их можно в Storage Adapter. Заметьте у каждого представлен тут сразу WWN.

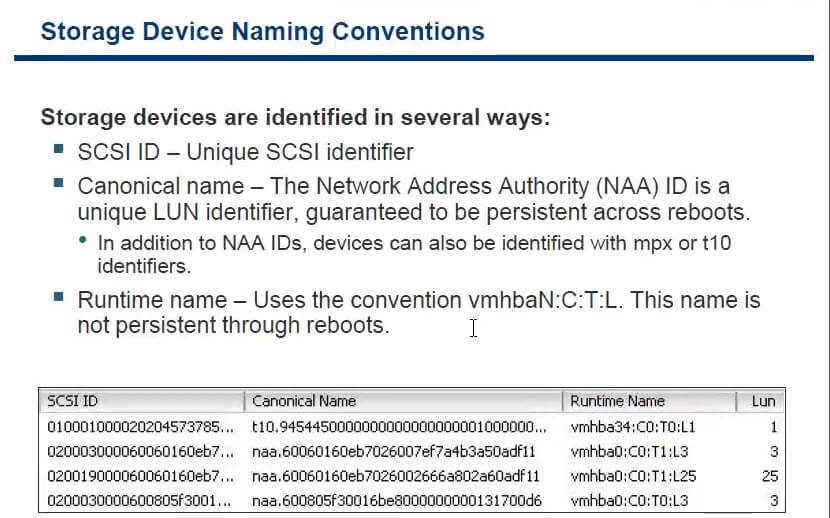

Каждый SCSI ID уникальный и имеет некое каноническое имя. Runtime name можно сравнить с WWN или mac адресом, по сути это уникальный идентификатор устройства в esxi.

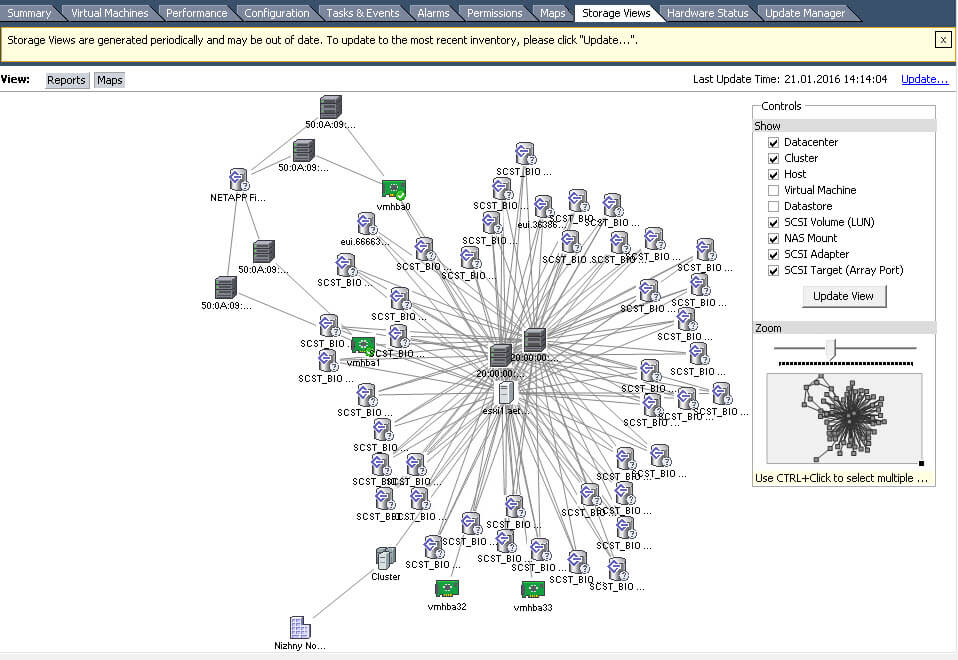

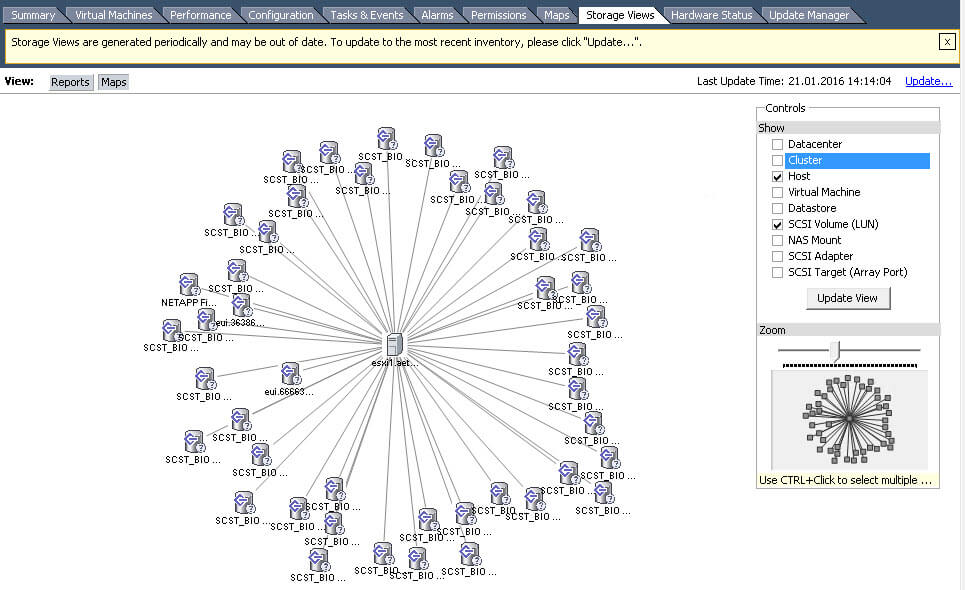

В VMware ESXi 5.5 есть очень удобная карта датасторов и устройств через, которые они подключены. Посмотреть данную карту можно в Storage Views

Удобно можно по фильтровать, убрав соответствующие галки с правой стороны.

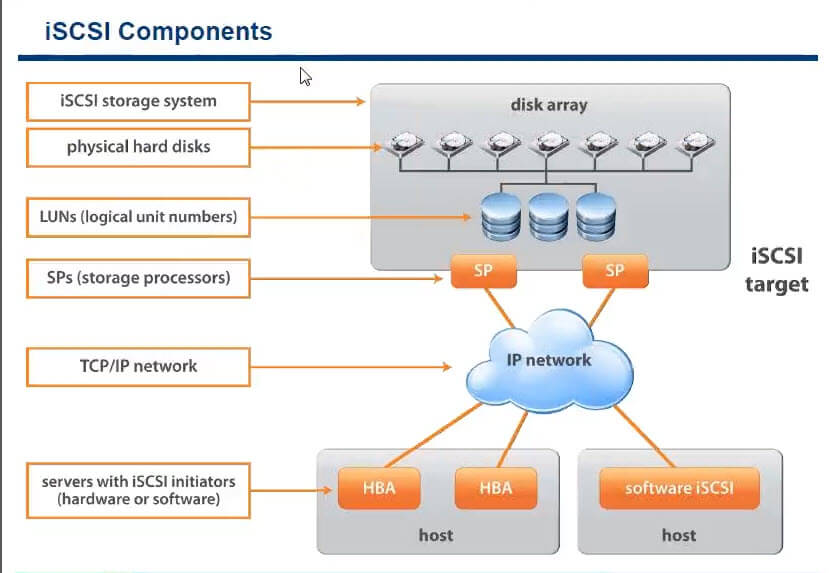

ISCSI компоненты

И так ранее я рассказывал как подключить iscsi диск к VMware ESXI 5.5, ознакомьтесь кто хочет попрактиковаться, мы же рассмотрим как это работает. И так есть сервер на котором установлена, не важно какая операционная система, она предоставляет нарезанные луны, нарезанные на физических дисках. У данного сервера есть такой параметр (адрес) ISCSI target, цель к которой мы будем подключаться. Далее по обычной ethernet сети, по TCP/IP, хост с гипервизором, подключается к ISCSI targe, за счет ISCSI Initiators (софтового или железного о них ниже). В итоге хост получает нужные ему lun, форматирует их и все.

Преимущества и недостатки ISCSI

- Легкость внедрения, данная технология уже легко идет в коробке с Windows Server 2008 R2 и выше, просто компонент, настроил и забыл

- Очень дешево, не нужно ничего кроме сетевой карты

- Не нужно ничего докупать

- Расстояние подключения, довольно высокое, хоть в соседний город, но будет скорость зависимая от интернета конечно, оптике проигрывает на порядок.

- Из недостатков, скорость, ограниченная сетевой картой и скоростью коммутатора, хотя есть возможность на нем настроить LACP да и на самом target, тоже можно сделать nic teeaming, за счет чего увеличить пропускную способность

- соединение не совсем надежное, если нет дублирования конечно

- нагрузка на вычислительные мощности процессора

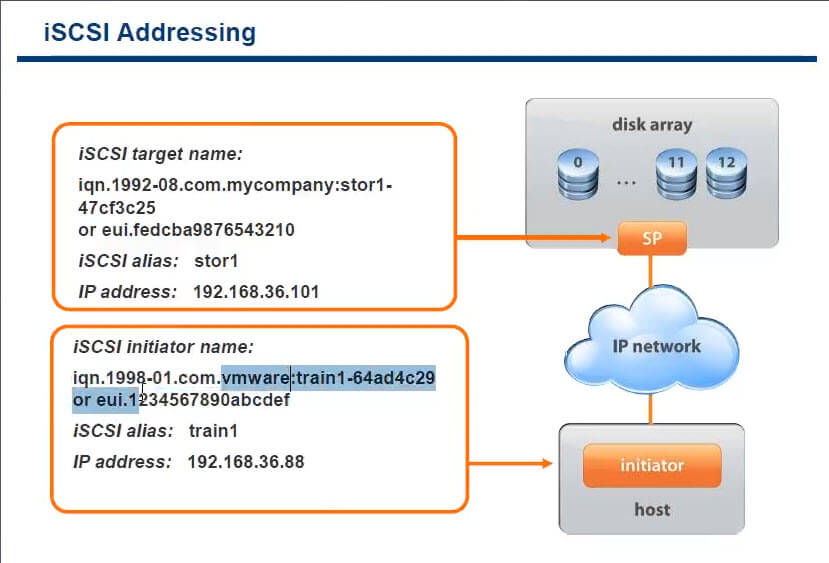

В качестве адресации в ISCSI taget или ISCSI initiator, используются аля wwn, под названием IQN. IQN это уникальный идентификатор устройства в рамках ISCSI сети.

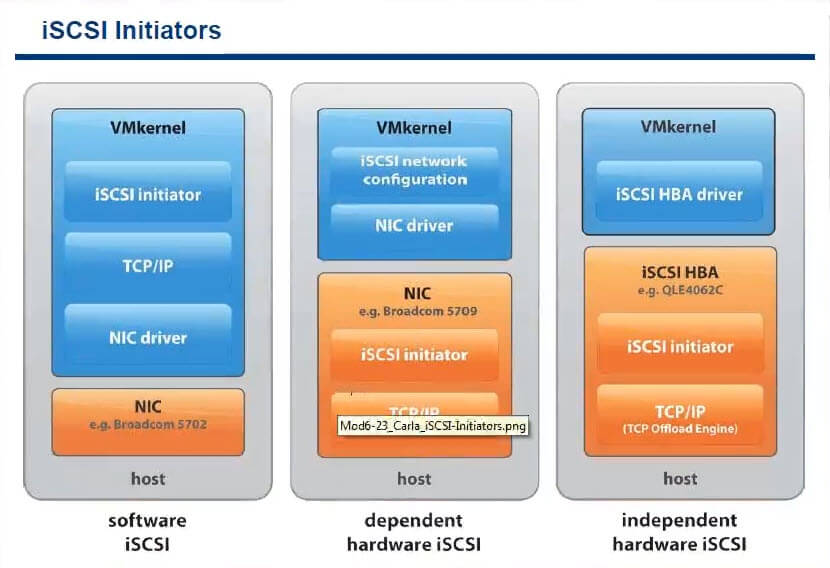

Виды ISCSI initiators

- Софтовые идут в комплекте ESXI или Windows например

- Физические зависимые > тут инкапсуляция и обработка трафика делается карточкой, но все равно используется процессор

- Физические не зависимые > тут весь ISCSI трафик обрабатывается за счет мощностей железки, тем самым снимая нагрузку с CPU.

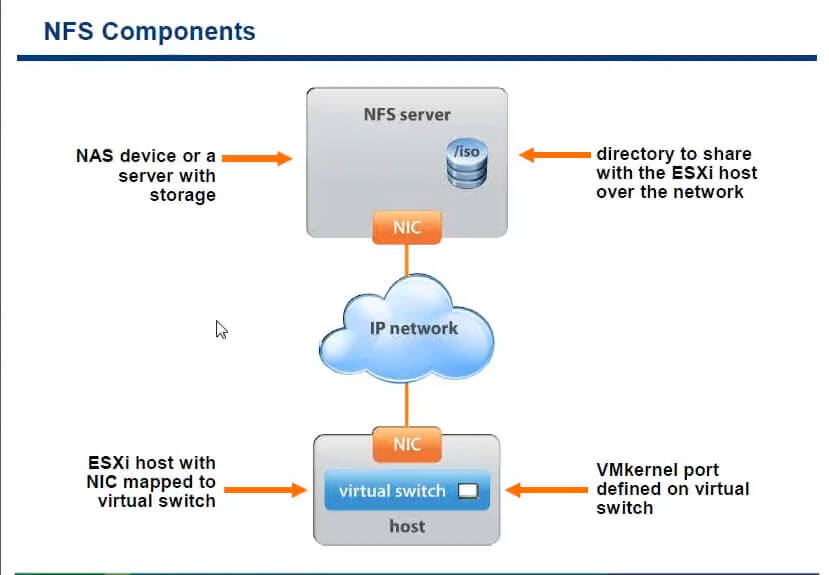

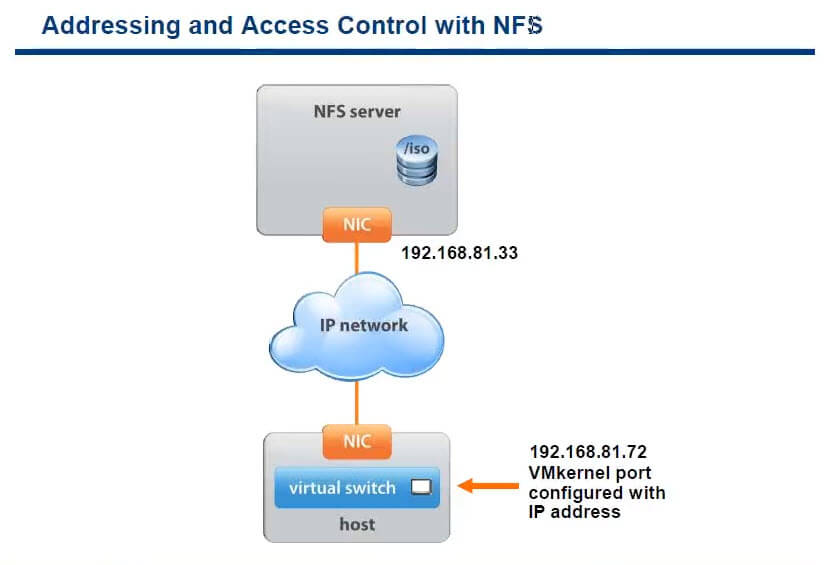

NFS компоненты

Довольно старый протокол, как его настраивать nfs в esxi я уже рассказывал, можете ознакомиться.

- Довольно легко внедряется

- не требует дополнительных вложений

- Используется для общего доступа для хостов, например датастор с дистрибутивами

- Из минусов, зависим по скорости, если скорость передачи стала слишком маленькой, встает напрочь

- Накладные расходы на передачу данных, на инкапсуляцию пакетов

Ниже представлен пример адресации NFS, схема очень простая.

Выводы

Материал сайта pyatilistnik.org

![Ошибка запуска VM: File system specific implementation of Ioctl[file] failed Ошибка запуска VM: File system specific implementation of Ioctl[file] failed](https://pyatilistnik.org/wp-content/uploads/2023/07/file-system-specific-implementation-150x150.png)

Я очень благодарен за ваш блог, каждый раз нахожу в нем что-то новое и интересное.