raid 5 ужас на своем опыте

Всем привет, я знаю, что у многих уже проскакивала тема опыта работы с RAID 5, я лишь хочу рассказать про свой, а именно как этот вид рейд массива работает с ссд дисками, и о подводных камнях. Знание данной информации, поможет вам избежать больших проблем и сэкономить много нервных клеток, так что потратьте некоторое время на знакомство с данным материалом, удачного прочтения. Все вопросы и пожелания, жду в комментариях, внизу статье.

И так ранее я рассказывал как тестировал RAID контроллер P410i на сервере HP ProLiant DL380 G7, данный контроллер в принципе их на троечку тащит, выжать из него можно на чтение 50 000 Iops, Ну суть не в этом, ранее я на нем создавал RAID 5 из 6 ssd дисков Samsung evo 850, к сожалению, данный контроллер не умеет выдавать показатели smart дисков, поэтому, через год, было примерное понимание, что ssd должны уже изнашиваться, при том уровне записи, и мы их начали менять. Я как думал это же ссд 🙂 и перестройка будет быстрой, ага raid 5 из 6 твердотельных дисков перестраивался аж 32 часа, напомню каждый диск по 1 ТБ, это просто ужас конечно. Я всегда был противником данного рейда, но всегда были, но в плане дешевизны и максимальном объеме полезного пространства, а вот его недостатки всегда отходили на второй план.

Проблемы raid 5

- Отказоустойчивость всего 1 диск > это очень плохо, особенно если у вас во время перестройки выйдет еще один диск из строя, так как на другие диски в данный момент будет повышенная нагрузка

- Время перестройки > при нынешних объемах это просто трешь, в моем случае raid 5, на ssd дисках перестраивался 32 часа, а что если бы у вас были обычные HDD объемом 4 и более ТБ, а как быть с ссд 10 тб, это просто жесть, в таком случае рейд уже начинает отмирать и перерастать в какие-то более умные файловые структуры, по типу того же Nutanix

- Вечная нервотрепка для админа 🙂 , но у него то их до фига же.

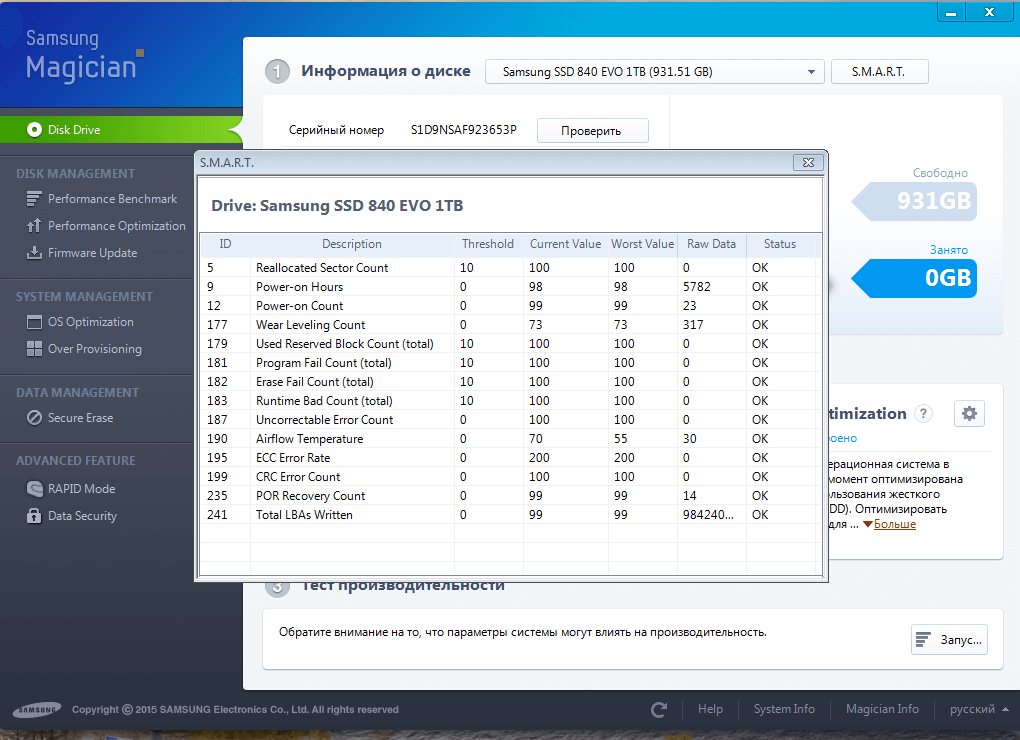

В моем случае износ диска составил всего 30 процентов за 240 дней, что для продакшена просто офигенно, спасибо виртуализации, так как на уровне гипервизора лежит просто один здоровый файл или несколько, у него, конечно, обновляются метаданные, но не так, если бы данный ссд диск был воткнут внутри ос.

Для примера напомню вам как считать жилец диск по smart показателям или нет, тут все просто есть поле Threshold которое показывает минимальное значение ниже которого нельзя опускаться, а в Current Value текущее, которое со временем уменьшается. Поле Wear Leveling Count показывает в процентах, скока еще осталось здоровья.

Резюмируя подведем итог, если у вас есть возможность не использовать RAID 5, то делайте другие виды RAID, например 60 или 10, все будет надежнее и по скорости быстрее, главное вам необходимо донести до своих заказчиков, что возможные проблемы могут с лихвой перекрыть все плюсы, данной реализации, ведь самая большая задача любого it бизнеса это минимизация простоя сервисов.

А вы используете RAID 5? напишите в комментариях

интересно, что в скрине 840 самсунг, а не 850

они не ент граде, а простые любительские, 850 уже получше должны были быть с 3д архитектурой

насчет 32 часов — контроллер слабый и не умеет понимать ссд, сейчас должны бить прошивки под ссд кеширование например, тогда и обычные диски быдут летать.

насчет рейдов — альтернативы типа нетаппа, zfs в резлисациях типа freenas и тд должны быть адекватны как скоростям, так и ребилдам

еще так долго он мог перестраивать потому что у него стоит write back a не write through, размерами кластера надо поиграться, для большого файла гипервизора кластер должен быть максимальмым и тд

мы как раз 840 на 850 заменяли, покапали их тогда, когда не было еще 850, спасибо за советы, у нас реально стоит write back чтобы iops побольше было, write through при линейной записи и чтении получше конечно. А контроллер на G7 старенький, тут я не спорю, просто удивился, что на столько долго

вот пример одного из миллиона карт, у производителя куча опций, можно вставлять в старые сервера

_ttp://www.highpoint-tech.com/USA_new/series_RC3240X8.htm

да кто спорит, что карт много, в России к сожалению, денег на все не дают и в 99 процентах случаев, конвергентные зоопарки, со временем посмотрю как с этим LSI 9361-8i справится

Не думаю, что RAID60 будет перестраиваться быстрее RAID5.

Он надежнее, а это существенно, так как во время перестройки другие диски очень проседают, особенно на нагруженных серверах, и выход еще одного диска все убьет, при 60 запас один диск есть, еще.

Иван, у вас мнение на счет SSD RAID5 на других контроллерах не изменилось? не тестировали? Нам предлагают RAID 5 (4+1) + Spare диск в СХД. Там аппаратный контроллер с кешем. Общий объем около 4Тб. Диски конечно enteprise class. Все равно ребилд будет идти также долго?

Тут все зависит от вашей задачи в проекте. Если это не особо нагруженный по iops проект, то при условии, что есть ограничение бюджета, то RAID-5 подойдет + hotspare, но по себе знаю, что лучше выбирать более надежные виды RAID. Плюс нужно смотреть какой у вас контроллер и enteprise class SSD. Я бы на вашем месте попросил вендора дать возможность погонять оборудование либо у вас, либо на его удаленной площадке. Можете его нагрузить и сымитировать выход из строя одного из дисков и посмотреть работу hotspare и время перестройки, плюс как будет отвечать сервис во время этого процесса.

Так зачем для сервера и продакшена брать десктопные диски, вот и износ, вот и нервы, ну зато сэкономили

ssd диск enterprise типа стоит не 5 т.р., а 35 т.р. напр Samsung PM863

Бюджет в тот момент был такой исключительно по финансовым соображениям.